OpenAI重磅资讯发布免费大模型GPT-4o, 更快、更智能、更安全

太平洋时间2024年5月13号上午10点,OpenAI春季发布会携GPT-4o重磅来袭。OpenAI首席技术官 Mira Murati 表示,更新后的模型“速度更快”,并提高了“文本、视觉和音频方面的功能”。它将免费向所有用户开放,付费用户将继续“拥有免费用户五倍的容量限制”。

GPT-4o 中的“o”代表“omni”,指的是GPT-4o的多模态(全能),是朝着更自然的人机交互迈出的一步——它接受文本、音频和图像的任意组合作为输入,并生成文本、音频和图像的任意组合输出。

它可以在短至232毫秒的时间内响应音频输入,平均响应时间为320毫秒(接近人类对话中的响应时间)。虽然在英语文本和代码方面,GPT-4o与GPT-4 Turbo的性能相当,但在非英语文本方面有了显著改进,不仅速度更快,同时API费用降低了50%,是GPT-4 Turbo的一半与现有模型相比,GPT-4o在视觉和音频理解方面表现尤为出色。

以下为新模型能力的展示

01 能力探索

02 模型评估

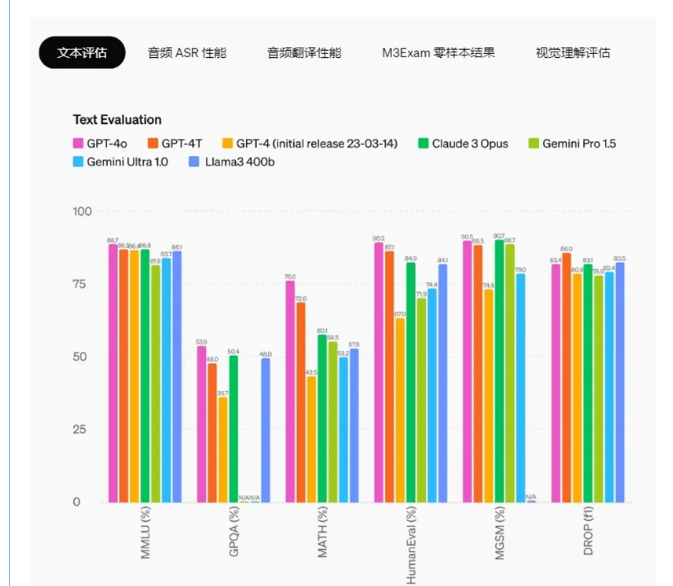

通过传统的基准测试后发现,

GPT-4o在文本、推理和编码智能方面达到了GPT-4 Turbo级别性能,

同时在多语种、音频和视觉能力方面创造了

新的里程碑

推理能力增强——GPT-4o 在 0 次 COT MMLU(常识问题)上创下了 88.7% 的新高分。所有这些评估都是使用OpenAI的新的simple evals库进行收集的。此外,在传统的 5 次无 CoT MMLU 上,GPT-4o 创下了 87.2% 的新高。

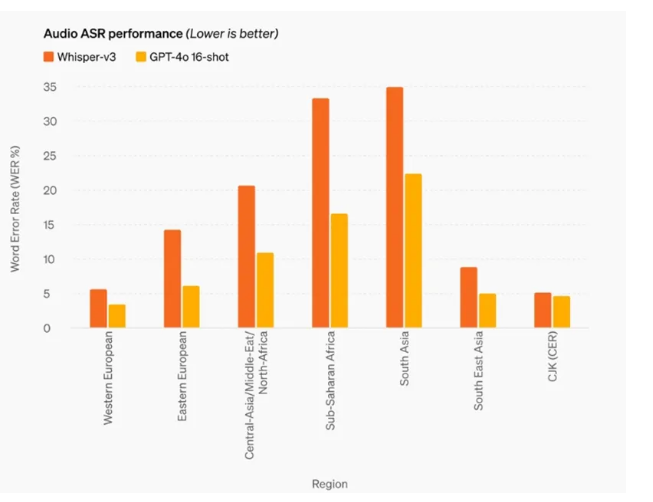

>>> 音频ASR性能

与Whisper-v3相比,GPT-4o显著提高了所有语言的语音识别性能,特别是对于资源匮乏的语言。

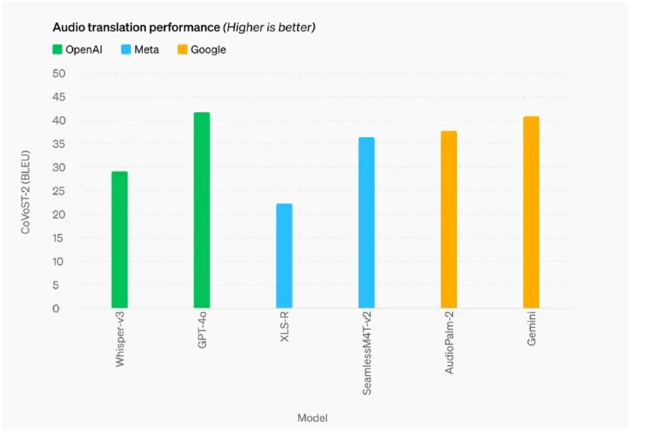

>>> 音频翻译性能

GPT-4o在语音翻译方面达到了新的最先进水平,并且在MLS基准测试中优于 Whisper-v3。

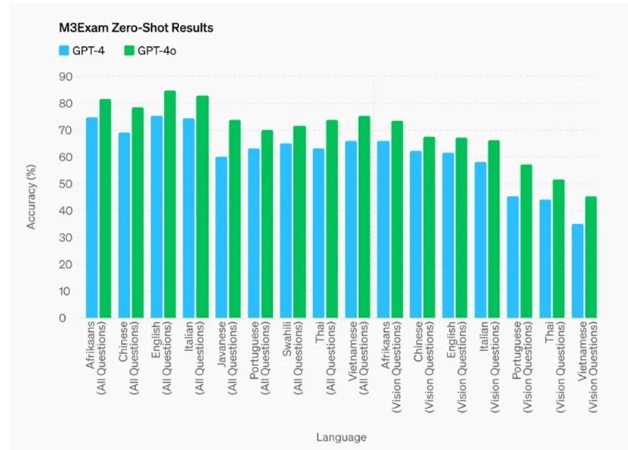

>>> M3Exam 0-Shot结果

M3Exam-基准测试既是多语言评估也是视觉评估,包括其他国家标准化测试的多项选择题,有时还包括图形和图表。在所有语言的基准测试中,GPT-4o表现得都比GPT-4更强(团队省略了斯瓦希里语和爪哇语的视力结果,因为这些语言的视力问题只有 5 个或更少)。

👇如果想了解更多有关GPT-4的内容,点击下面链接即可查看👇

https://www.semrush.com/blog/gpt-4

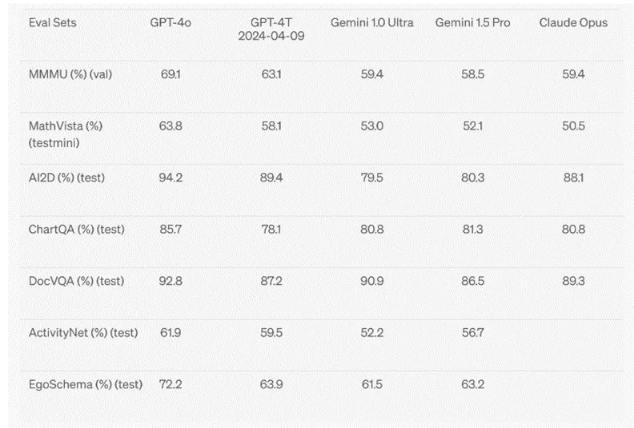

>>> 视觉理解评估

在图片视觉理解评估方面,GPT-4o在视觉感知基准测试上达到了最先进的性能。所有视觉评估都是0-shot,包括MMMU、MathVista和ChartQA。

03 语言标记

以下 20 种语言被选为新标记器在不同语言家族中压缩的代表

04 模型安全和限制

GPT-4o通过各种技术来确保安全,采用了过滤训练数据和通过后期训练完善模型行为等技术。并且创建了新的安全系统,来为语言输出提供防护措施。

另外,OpenAI还根据准备框架和自愿承诺,对GPT-4o进行了评估。在网络安全、CBRN(化学、生物、辐射和核)风险、说服力和模型自主性方面的评估显示,GPT-4o在任何一个类别中的风险评级均未到达中等以上。这一评估包括在整个模型训练过程中进行一系列自动和人工评估:测试了模型在安全缓解措施前后的版本,使用了自定义的微调和提示,以更好地引发模型的能力。

除此之外,GPT-4o还经过了70多名外部专家在社会心理学、偏差和公平性、虚假信息等领域的大量外部红队测试,来确定新增模态会引入或放大的风险。利用这些经验来完善安全干预措施,以提高与GPT-4o交互的安全性。

05 模型可用性

GPT-4o是OpenAI在深度学习领域的最新进展,也是朝着实际可用性的方向迈出的一步。在过去两年OpenAI团队一直致力于提高技术栈的各个层面的效率, GPT-4o就是这项工作的首个成果,并且其功能将以迭代的方式逐渐提升。

ChatGPT中已经推出GPT-4o的文本和图像功能(会在免费版和Plus版本中提供),未来几周内还将在ChatGPT Plus中推出带有GPT-4o的语音模式的新版本。

开发者现在可以通过API访问GPT-4o作为文本和视觉模型,与GPT-4 Turbo相比,GPT-4o更快、价格更低且速率限制提高了5倍。OpenAI还计划在未来几周内,将GPT-4o的新音频和视频功能支持添加到API中,但目前仅对少数可信赖的合作伙伴开放。