由华裔女科学家、“人工智能教母”李飞飞联合领导的斯坦福大学以人为本人工智能研究所(Stanford HAI)近日发布了:《2024年人工智能指数报告》(Artificial Intelligence Index Report 2024)。

斯坦福大学HAI介绍称,人工智能指数报告跟踪、整理、提取和可视化与人工智能相关的数据。该研究所的使命是提供不带偏见的、经过严格审查的、来源广泛的数据,以便政策制定者、研究人员、高管、记者和公众对复杂的人工智能领域有更深入细致的了解。人工智能指数是全球公认的最可信和最权威的人工智能数据和见解来源之一。

Shulex 将此报告的 10 个重点议题分为 10 次内容为您进行翻译和更新,以下为此次报告的基础介绍及第一章 :研究与发展部分的具体内容!如果您希望尽快学习整篇内容,您可以扫码咨询Shulex小助手领取《2024年人工智能指数报告》(Artificial Intelligence Index Report 2024)英文版原版PDF文件,谢谢!

2024年AI指数报告介绍

欢迎来到第七版AI指数报告。2024年指数是我们迄今为止最全面的指数,在AI对社会的影响从未如此明显的重要时刻到来。今年,我们扩大了研究范围,更广泛地涵盖了AI的技术进步、公众对该技术的看法以及围绕其发展的地缘政治动态等基本趋势。该版本提供了比以往更多的原始数据,介绍了对AI培训成本的新估计,对负责任的AI前景的详细分析,以及专门介绍AI对科学和医学影响的全新章节。AI指数报告跟踪、整理、提炼和可视化与人工智能(AI)相关的数据。

我们的使命是提供公正、严格审查、来源广泛的数据,以便政策制定者、研究人员、高管、记者和公众对复杂的AI领域有更全面、更细致的了解。AI指数是全球公认的最可信、最权威的人工智能数据和见解来源之一。之前的版本曾被《纽约时报》、《彭博社》、《卫报》等主要报纸引用,积累了数百次学术引用,并被美国、英国、欧盟等地的高层决策者引用。今年的版本在规模、规模和范围上都超过了以往的所有版本,反映了AI在我们生活中越来越重要。

联合致辞:

十年前,世界上最好的AI系统还无法像人类一样对图像中的物体进行分类。AI难以理解语言,也无法解决数学问题。如今,AI系统在标准基准上的表现经常超过人类。2023年,这一进程加速。像GPT-4、Gemini和Claude 3这样最先进的新系统是令人印象深刻的多模态:它们可以生成数十种语言的流畅文本,处理音频,甚至解释模因。随着AI的进步,它越来越多地进入我们的生活。公司正在竞相开发基于人工智能的产品,AI越来越多地被公众使用。但目前的AI技术仍然存在重大问题。它不能可靠地处理事实,执行复杂的推理,或者解释它的结论。AI面临两个相互关联的未来。

首先,技术不断改进并被越来越多地使用,对生产力和就业产生重大影响。它可以有好的用途,也可以有坏的用途。在第二个未来,AI的采用受到技术局限性的限制。无论未来如何展开,各国政府都越来越关注。他们正在介入以鼓励有利的一面,例如资助大学研发和激励私人投资。政府也致力于管理潜在的负面影响,例如对就业、隐私问题、错误信息和知识产权的影响。随着AI的迅速发展,AI指数旨在帮助AI社区、政策制定者、商业领袖、记者和公众应对这一复杂的局面。它提供了持续、客观的快照,跟踪几个关键领域:AI能力的技术进步,推动AI开发和部署的社区和投资,对当前和潜在未来影响的公众舆论,以及为刺激AI创新而采取的政策措施,同时管理其风险和挑战。

通过全面监测AI生态系统,该指数是了解这一变革性技术力量的重要资源。在技术方面,今年的AI指数报告称,2023年全球发布的新型大型语言模型的数量比前一年翻了一番。其中三分之二是开源的,但表现最好的模型来自拥有封闭系统的行业参与者。

Gemini Ultra成为第一个在大规模多任务语言理解(MMLU)基准上达到人类水平的LLM;自去年以来,在基准测试上的性能提升了15个百分点。此外,GPT-4在语言模型综合整体评估(HELM)基准上取得了令人印象深刻的0.96平均胜率得分,其中包括MMLU和其他评估。虽然全球对AI的私人投资连续第二年减少,但对生成式AI的投资却飙升。财富500强公司的财报电话会议中提到AI的次数比以往任何时候都多,新的研究表明,AI确实提高了员工的生产率。在政策制定方面,全球立法程序中对AI的提及从未如此之高。美国监管机构在2023年通过的人工智能相关法规比以往任何时候都多。

尽管如此,许多人对AI制造深度造假和影响选举的能力表示担忧。公众对AI的意识越来越强,研究表明,他们的反应是紧张。Ray Perrault and Jack ClarkCo-directors, AI Index

十大启示:

1. A人工智能在某些任务上胜过人类,但并非在所有任务上。在一些基准测试中,人工智能的表现已经超过了人类,包括在图像分类、视觉推理和英语理解方面。然而,在竞赛级数学、视觉常识推理和规划等更复杂的任务上,人工智能却落后于人类。

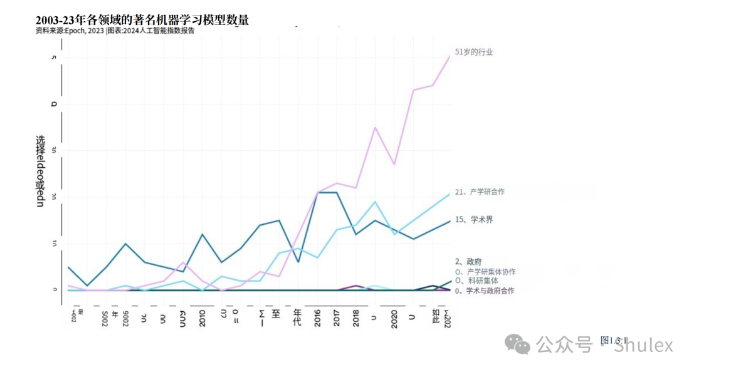

2. 工业界继续主导人工智能前沿研究。2023 年,产业界产生了 51 个著名的机器学习模型,而学术界只贡献了 15 个。2023 年,产学合作还产生了 21 个著名模型,创下新高。2023年,工业界产生了51个值得注意的机器学习模型,而学术界仅贡献了15个。

3. 前沿模型越来越昂贵。据 AI Index 估计,最先进的人工智能模型的训练成本已经达到了前所未有的水平。例如,OpenAI 的 GPT-4 估计使用了价值 7800 万美元的计算资源进行训练,而谷歌的 Gemini Ultra 则耗费了 1.91 亿美元的计算资源。 根据AI指数的估计,最先进的AI模型的培训成本已经达到了前所未有的水平。

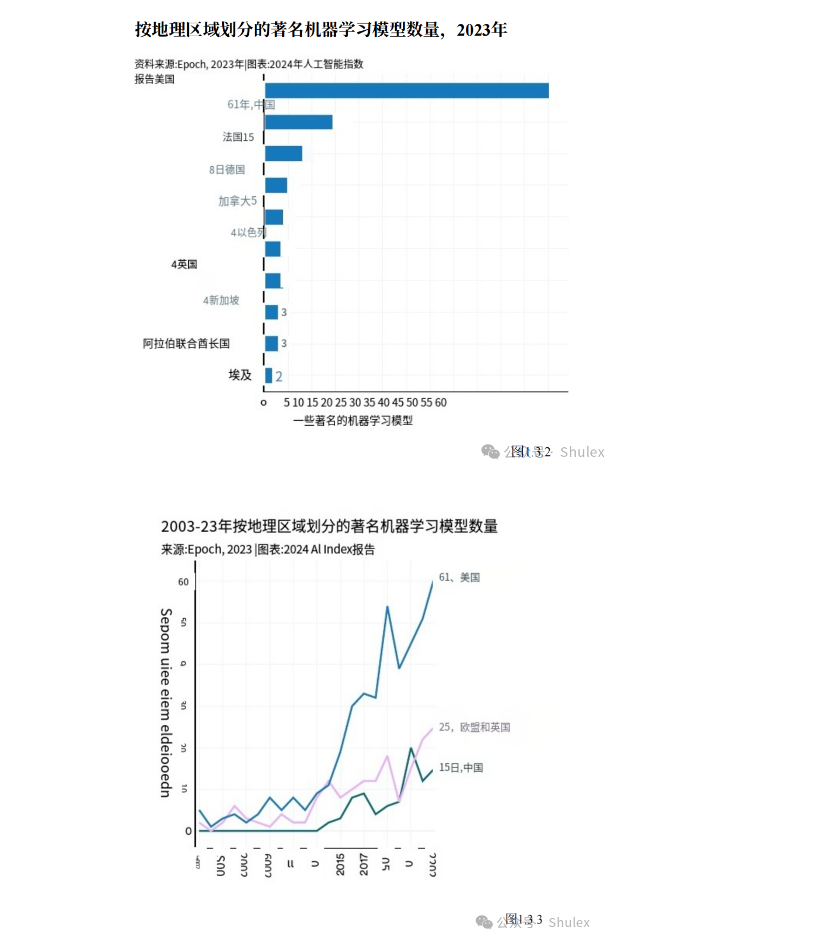

4. 美国领先于中国、欧盟和英国,成为顶级人工智能模型的主要来源国。2023 年,61 个著名的人工智能模型源自美国的机构,远远超过欧盟的 21 个和中国的 15 个。2023年,61个著名的AI模型来自美国的机构,远远超过欧盟的21个和中国的15个。

5.目前严重缺乏对 LLM 责任的可靠和标准化评估。 包括 OpenAI、谷歌和 Anthropic 在内的领先开发者主要根据不同的责任人工智能基准来测试自己的模型。这种做法使得系统地比较顶级人工智能模型的风险和局限性的工作变得更加复杂。

6. 生成式人工智能投资激增。尽管去年整体人工智能私人投资有所下降,但用于生成式人工智能的资金却激增,比2022年增长了近八倍,达到252亿美元。生成式人工智能领域的主要参与者,包括 OpenAI、Anthropic、Hugging Face 和 Inflection,都报告了一轮可观的融资。生成式AI领域的主要参与者,包括OpenAI、Anthropic、hugs Face和Inflection,都报告了大量融资。

7. 数据显示人工智能让工人更有生产力,工作质量更高。2023 年,几项研究评估了人工智能对劳动力的影响,表明人工智能使工人能够更快地完成任务,并提高产出质量。这些研究还表明,人工智能有可能缩小低技能和高技能工人之间的技能差距。不过,其他研究也提醒说,在没有适当监督的情况下使用人工智能可能会导致绩效下降。

8. 得益于人工智能,科学进步进一步加速。2022 年,人工智能开始推动科学发现。然而,2023 年,与科学相关的更重要的人工智能应用相继问世–从提高算法排序效率的 AlphaDev,到促进材料发现过程的 GNoME。 然而,2023年,我们看到了更重要的与科学相关的AI应用程序的推出——从提高算法排序效率的AlphaDev,到促进材料发现过程的GNoME。

9. 美国人工智能法规数量急剧增加。美国人工智能相关法规的数量在过去一年和过去五年中大幅增加。2023 年,人工智能相关法规将从 2016 年的 1 项增加到 25 项。仅去年一年,人工智能相关法规的总数就增长了 56.3%。到2023年,有25项人工智能相关法规,而2016年只有一项。

10. 益普索的一项调查显示,在过去的一年里,认为AI将在未来三到五年内极大地影响他们生活的人的比例从60%上升到66%。此外,52%的人对AI产品和服务表示紧张,比2022年上升了13个百分点。在美国,皮尤研究中心的数据显示,52%的美国人对AI感到担忧甚于兴奋,而2022年这一比例为37%。以下为报告相关贡献者及组织:(此处不做翻译)

本篇内容主要为您分享,第一章:研究与发展!

第 一 章 :研究与发展

概述

本章研究了AI研究与发展的趋势。它首先检查趋势出版物和专利,然后检查著名的AI系统和基础模型的趋势。最后分析了AI会议出席情况和开源AI软件项目。

第 一 章 :研究与发展

1. 工业界继续主导前沿人工智能研究

2023年,工业界产生了51 个值得注意的机器学习模型,而学术界只贡献了15个。2023年产学合作产生的值得注意的模型也有21个,再创新高。

2. 更多的基金会模型和更开放的基金会模型。

2023年,共有149个基金会发布了款型,比2022年发布的数量增加了一倍多。在这些新发布的机型中,开源机型占65.7%,而2022年和2021年这一比例分别仅为44.4%和33.3%。

3. 前沿机型的价格要贵得多。

根据人工智能指数的估计,最先进的人工智能模型的培训成本已经达到了前所未有的水平。例如,OpenAI的GPT-4使用了价值约7800万美元的计算进行训练,而谷歌的Gemini Ultra则花费了1.91亿美元的计算成本。

4. 美国领先中国、欧盟和英国,成为顶级人工智能模型的主要来源。

2023年,61个著名的人工智能模型来自美国的机构,远远超过欧盟的21个和中国的15个。

5. 人工智能专利数量激增。

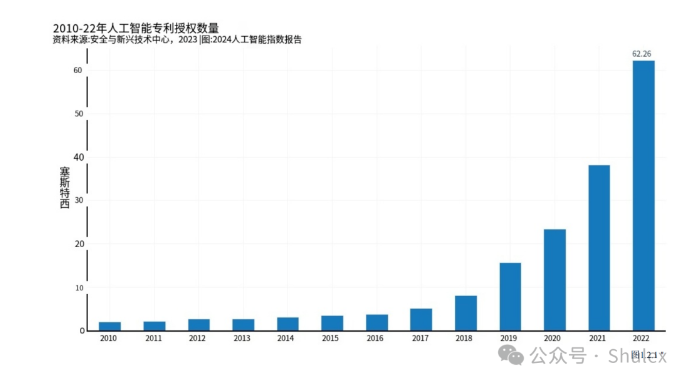

从2021年到2022年,全球人工智能专利授权大幅增长62.7%。自2010年以来,获得授权的人工智能专利数量增长了31倍以上。

6. 中国主导着人工智能专利。

2022年,中国以61.1%的比例领先全球人工智能专利起源,显著超过美国的20.9%。自2010年以来,美国在人工智能专利中的份额从54.1%下降。

7. 开源人工智能研究爆发。

自2011年以来,GitHub上的人工智能相关项目数量持续增长,从2011年的845个增长到2023年的180万个。值得注意的是,仅在2023年,GitHub人工智能项目总数就急剧增长了59.3%。GitHub上人工智能相关项目的星级总数在2023年也大幅增加,从2022年的400万增加到1220万,增加了两倍多。

8. 人工智能出版物的数量持续上升。

2010年至2022年间,人工智能出版物的总数几乎增加了两倍,从2010年的约8.8万篇增加到2022年的24万多篇。与去年相比,这一增幅仅为1.1%。

part1 1.1 出版物

概 述

以下数字显示了2010年至2022年全球英语和中文人工智能出版物的数量,按隶属关系类型和跨部门合作分类。此外,本节还详细介绍了人工智能期刊文章和会议论文的出版数据。

人工智能出版物总数

图1.1.1显示了人工智能出版物的全局计数。2010年至2022年间,人工智能出版物的总数几乎增加了两倍,从2010年的约8.8万篇增加到2022年的24万多篇。与去年相比,这一增幅仅为1.1%

按出版类型划分

图1.1.2显示了全球AI发布类型随时间的分布情况。2022年,大约有23万篇AI期刊文章,而大约有4.2万篇会议论文。自2015年以来,ai期刊和会议出版物以可比的速度增长。2022年,会议出版物和期刊出版物的数量分别是2015年的2.6倍和2.4倍。

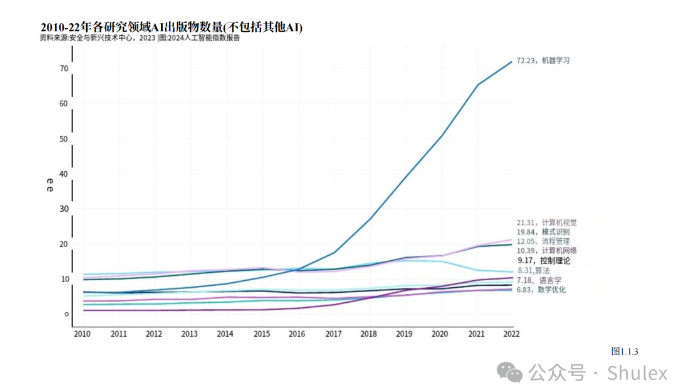

按研究领域划分

图1.1.3显示了自2010年以来按研究领域划分的AI出版物总数。机器学习出版物在过去十年中增长最快,自2015年以来增长了近7倍。继机器学习之后,2022年发表最多的AI领域是计算机视觉(21,309篇)、模式识别(19,841篇)和流程管理(12,052篇)。

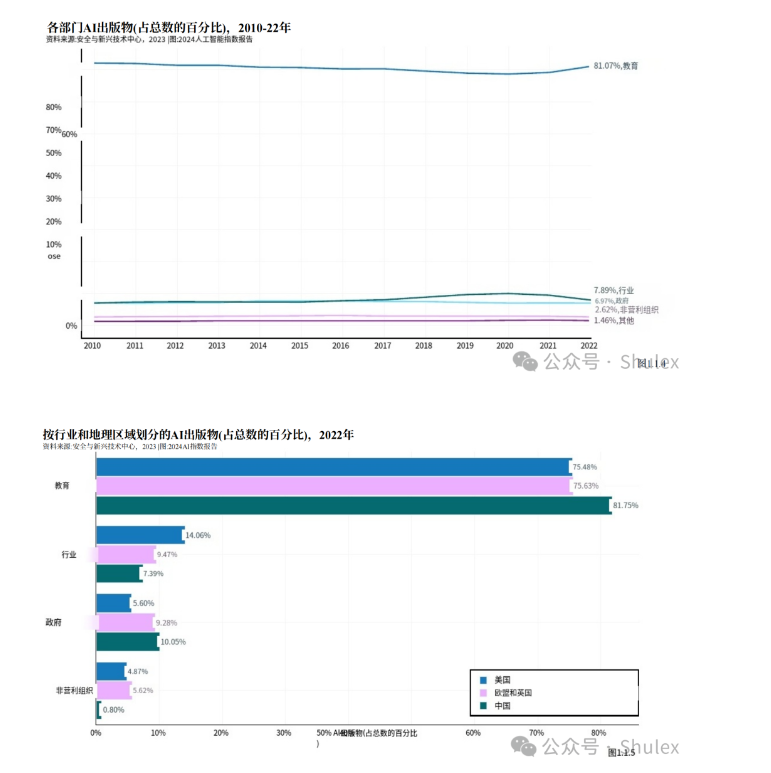

部门本节介绍了AI出版物在全球范围内的分布情况,包括教育、政府、行业、非营利组织和其他部门,以及具体在美国、中国、欧洲联盟加联合王国的分布情况。2022年,学术部门贡献了大部分人工智能出版物(81.1%),在过去十年中保持了其在所有地区AI研究全球领先来源的地位(图1.1.4和图1.1.5)。工业参与在美国最为显著,其次是欧洲联盟加联合王国和中国(图1.1.5)。

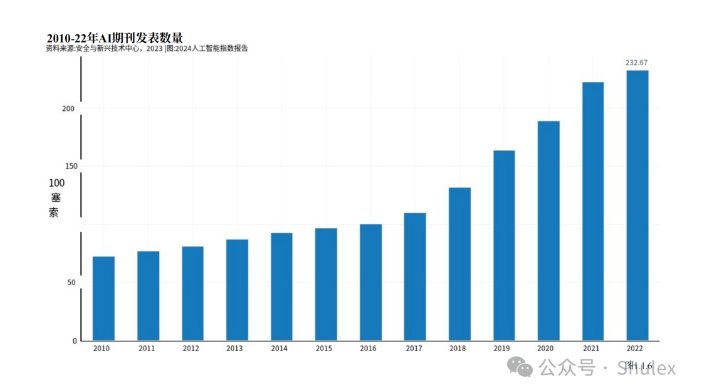

AI期刊图1.1.6显示了2010 – 2022年AI期刊发表总数。从2010年到2015年,AI期刊出版物的数量略有增长,但自2015年以来增长了约2.4倍。在2021年至2022年期间,AI期刊出版物增长了4.5%。

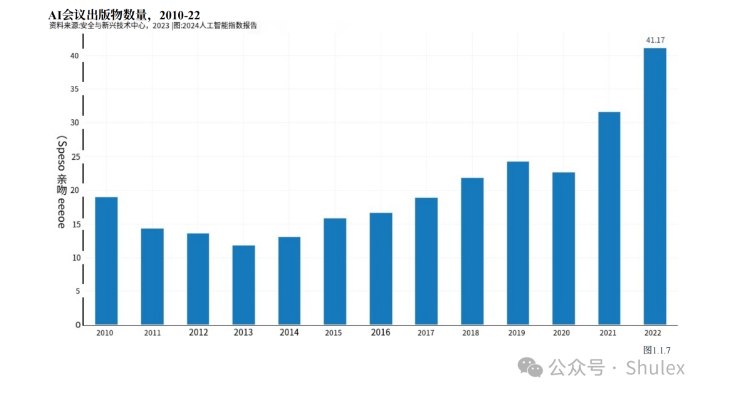

AI会议出版物

图1.1.7显示了自2010年以来AI会议出版物的总数。在过去的两年里,AI会议出版物的数量有了显著的增长,从2020年的22727篇上升到2021年的31629篇,到2022年达到41174篇。仅去年一年,AI会议出版物就增加了30.2%。自2010年以来,AI会议出版物的数量增加了一倍多。

part2

本节研究了全球AI专利的长期趋势,这可以揭示AI创新、研究和开发演变的重要见解。此外,分析AI专利可以揭示这些进步是如何在全球分布的。与出版物数据类似,AI专利数据的可用性也有明显的延迟,2022年是可访问数据的最近一年。本节数据来自CSET。

1.2 专利

AI专利

概述:

图1.2.1考察了2010年至2022年全球AI专利授权的增长情况。在过去十年中,AI专利数量显著增加,近年来增长尤为迅猛。例如,2010年至2014年间,AI专利授权总量增长了56.1%。然而,仅从2021年到2022年,AI专利数量就增长了62.7%。

按归档状态和地区划分

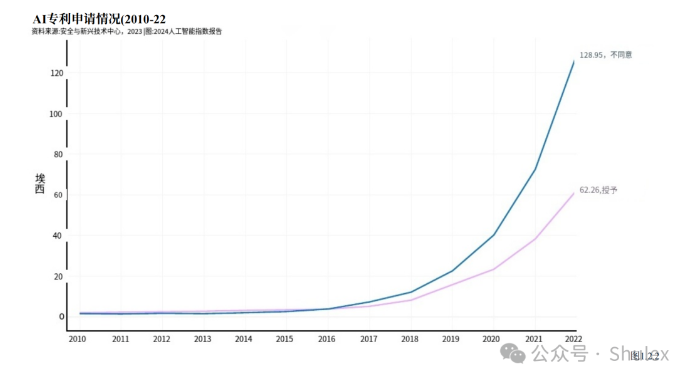

以下部分按AI专利的申请状态(是否授予)以及其发表的地区进行了分类。图1.2.2按申请状态对全球AI专利进行比较。2022年,未授权的AI专利数量(128952件)是授权数量(62264件)的两倍多。随着时间的推移,AI专利审批的格局发生了显著变化。直到2015年,申请的AI专利中获得授权的比例更大。然而,从那以后,大多数AI专利申请都没有获得批准,差距显著扩大。例如,2015年,42.2%的AI专利申请未获批准。到2022年,这一数字已上升至67.4%。

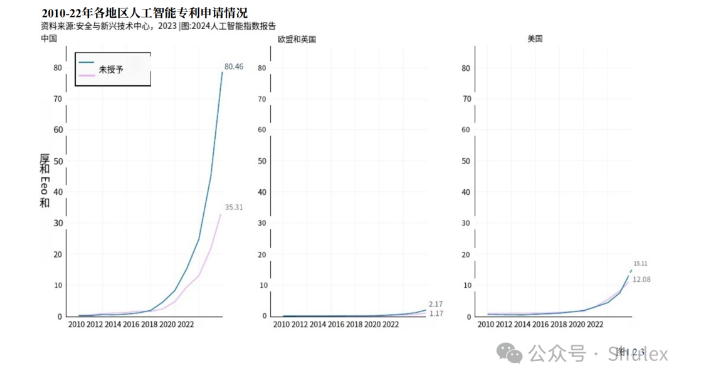

在包括中国、欧盟和英国以及美国在内的所有主要专利起源地理区域,授权和未授权AI专利之间的差距都很明显(图1.2.3)。近年来,这三个地理区域的AI专利申请总数和专利授权数量都有所增加。

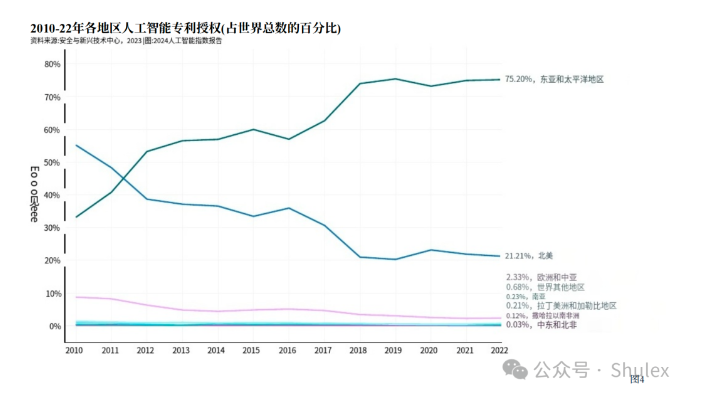

图1.2.4展示了授权AI专利的区域细分。截至2022年,世界上大部分已授予的AI专利(75.2%)来自东亚和太平洋地区,北美是第二大贡献者,占21.2%。截至2011年,北美在全球AI专利数量方面处于领先地位。然而,从那时起,发生了重大转变,来自东亚和太平洋地区的AI专利比例不断增加。

按地理区域划分,世界上大多数授予的AI专利来自中国(61.1%)和美国(20.9%)(图1.2.5)。来自美国的AI专利份额从2010年的54.1%下降。

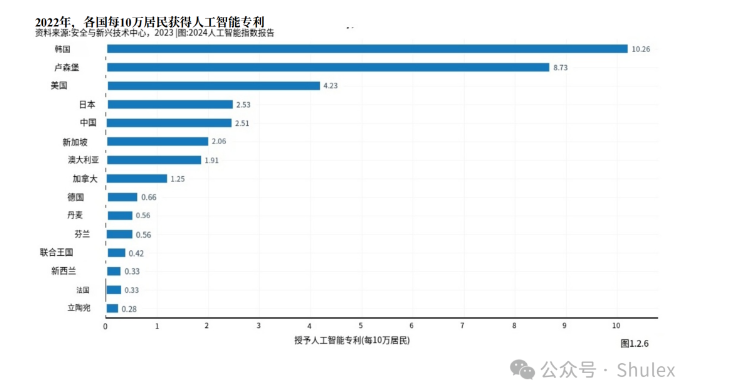

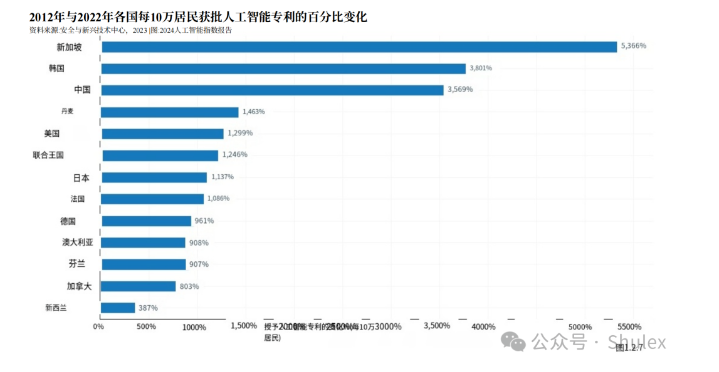

图1.2.6和图1.2.7显示了哪些国家在人均AI专利方面领先。2022年,每10万居民中获得AI专利最多的国家是韩国(10.3),其次是卢森堡(8.8)和美国(4.2)。(图)相对于1.2.6。图1.2.7显示了2012年至2022年人均AI专利授权的变化。在此期间,新加坡、韩国和中国的人均AI专利申请量增幅最大。

2012年 与 2022年各国每 10万居民获批人工智能专利的百分比变化

part3

本节探讨AI研究的前沿。虽然每年都会推出许多新的AI模型,但只有一小部分样本代表了最先进的研究。诚然,什么是先进或前沿研究多少有些主观。前沿研究可以反映一个模型在基准上发布一个新的最先进的结果,引入一个有意义的新架构,或者行使一些令人印象深刻的新功能。

人工智能指数研究两类前沿人工智能模型的趋势:“显著模型”和基础模型人工智能指数数据提供商Epoch使用“著名的机器学习模型”一词来指定精心挑选的在人工智能/机器学习生态系统中特别有影响力的值得注意的模型。相比之下,基础模型是在大量数据集上训练的非常大的人工智能模型,能够执行大量的下游任务。基础模型的例子包括GPT-4、Claude 3和Gemini。虽然很多粉底模特可能有资格成为知名模特,但并非所有知名模特都是粉底模特。

在本节中,人工智能指数从不同的角度探讨了著名模型和基础模型的趋势,包括原始组织、原产国、参数计数和计算使用情况。分析最后对机器学习培训成本进行了考察。

1.3 前 沿 人 工 智 能 研 究

通用机器学习模型

概述

Epoch人工智能是一组致力于研究和预测先进人工智能进化的研究人员。他们维护着一个自20世纪50年代以来发布的人工智能和机器学习模型数据库,根据最先进的技术进步、历史意义或高引用率等标准选择条目。通过分析这些模型,可以全面概述近年来和过去几十年机器学习领域的演变数据集中可能缺少一些模型;然而,数据集可以相对地揭示趋势。

行 业 分 析

直到2014年,学术界主导了机器学习模型的发布。从那以后,工业界就走在了前面。2023年,工业界产生了51个值得注意的机器学习模型,而学术界只有15个(图1.3.1)。值得注意的是,2023年有21个值得注意的模型是由行业/学术合作产生的,创历史新高。创建尖端的人工智能模型现在需要大量的数据、计算能力和财政资源,而这些在学术界是无法获得的。在去年的人工智能指数报告中,首次强调了这种向领先人工智能模型增加行业主导地位的转变。尽管今年差距略有缩小,但这一趋势在很大程度上仍然存在。

国家关系

为了说明不断变化的人工智能地缘政治格局,人工智能指数研究团队分析了著名模型的原产国。图1.3.2显示了归因于研究人员附属机构位置的显著机器学习模型的总数2023年,美国以61个著名机器学习模型领跑,中国以15个紧随其后,法国以8个紧随其后。自2019年以来,欧盟和英国生产的著名人工智能模型数量首次超过中国(图1.3.3)。自2003年以来,美国比英国、中国和加拿大等其他主要地理区域生产了更多的模型(图1.3.4)。

2003-23年按地理区域划分的著名机器学习模型数量 (sum)参数的趋势

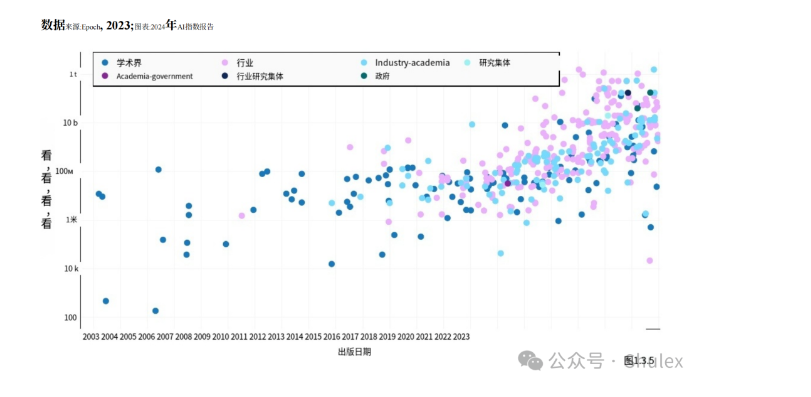

机器学习模型中的参数是在训练过程中学习到的数值,它决定了模型如何解释输入数据并进行预测。在更多数据上训练的模型通常会比在更少数据上训练的模型有更多的参数。同样,具有更多参数的模型通常优于具有更少参数的模型。图1.3.5展示了Epoch数据集中机器学习模型的参数计数,按模型起源的部门进行分类。自2010年代初以来,参数数量急剧上升,反映了AI模型设计任务的日益复杂、数据的可用性、硬件的改进以及更大模型的有效性。高参数模型在工业领域尤其引人注目,这凸显了OpenAI、Anthropic和Google等公司承担海量数据训练的计算成本的能力。

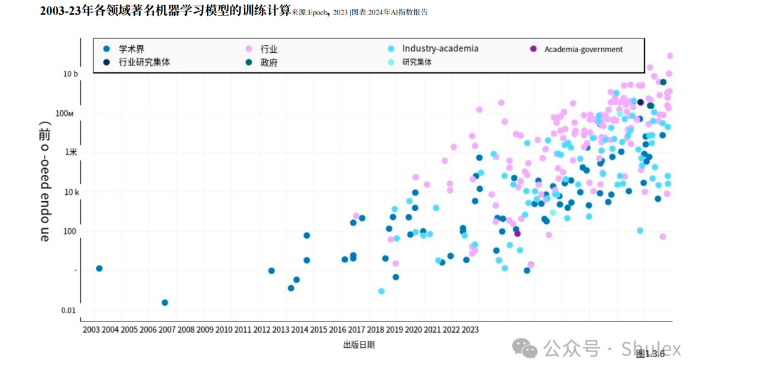

计算趋势

AI模型中的术语“计算”是指训练和操作机器学习模型所需的计算资源。一般是指模型的复杂程度和训练数据集的大小直接影响所需的计算量。模型越复杂,底层训练数据越大,训练所需的计算量就越大。图1.3.6可视化了过去20年著名机器学习模型所需的训练计算量。最近,著名的AI模型的计算使用量呈指数级增长这一趋势在过去五年中尤为明显。计算需求的快速增长具有至关重要的意义。例如,需要更多计算的模型通常具有更大的环境足迹,公司通常比学术机构拥有更多的计算资源。

图1.3.7突出显示了2012年以来著名机器学习模型的训练计算。例如,AlexNet是推广使用gpu改进AI模型的标准做法的论文之一,该论文估计需要470千万亿次浮点运算来进行训练。最初的Transformer于2017年发布,需要大约7400千万亿次浮点运算。谷歌的Gemini Ultra是目前最先进的基础模型之一,需要500亿次千万亿次浮点运算。

亮 点 :

模型会耗尽数据吗 ?

如上所示,最近很大一部分算法进步,包括强大的llm背后的进步,都是通过在越来越大的数据量上训练模型来实现的。正如Anthropic联合创始人兼AI指数指导委员会成员杰克·克拉克(Jack Clark)最近指出的那样,基金会模型已经在互联网上存在的所有数据中进行了有意义的训练。AI模型对数据的依赖性越来越大,这引发了人们的担忧,即未来几代计算机科学家将耗尽数据,无法进一步扩展和改进他们的系统。Epoch的研究表明,这些担忧在某种程度上是有道理的。

Epoch的研究人员已经对AI研究人员可能会在何时耗尽数据进行了历史和基于计算的预测。历史预测是基于观察到的用于训练基础模型的数据规模的增长率。计算预测根据计算可用性的预测来调整历史增长率。例如,研究人员估计,到2024年,计算机科学家可能会耗尽高质量语言数据的库存,在20年内耗尽低质量语言数据,并在2030年代末至2040年代中期耗尽图像数据(图1.3.8)。从理论上讲,数据可用性有限的挑战可以通过使用合成来解决类型对ML数据耗尽的预测:中位数和90% CI日期来源:Epoch, 2023 |表:2024 AIIndex报告

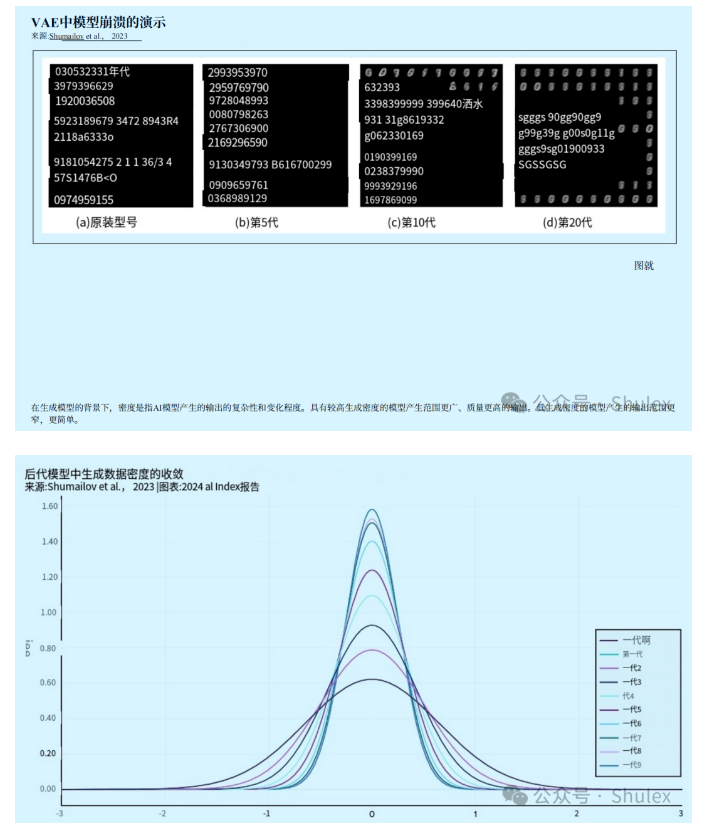

数据,这是AI模型本身产生的数据。例如,可以使用一个LLM生成的文本来训练另一个LLM。使用合成数据训练AI系统特别有吸引力,不仅因为它是潜在数据耗尽的解决方案,而且因为生成式AI系统原则上可以在自然发生的数据稀少的情况下生成数据,例如,罕见疾病或代表性不足的人口的数据。直到最近,使用合成数据训练生成式AI系统的可行性和有效性还没有得到很好的理解。然而,今年的研究表明,在合成数据上训练模型存在局限性。例如,一个由英国和加拿大研究人员组成的团队发现,模型主要是在合成数据经验模型上训练的崩溃,一种现象,随着时间的推移,他们失去了记住真实底层数据分布的能力,并开始产生一个狭窄的输出。

图1.3.9展示了变分自编码器(VAE)模型的模型崩溃过程,变分自编码器是一种广泛使用的生成式AI架构。随着后续每一代的训练额外的合成数据,模型产生的输出越来越有限。如图1.3.10所示,从统计学角度来看,随着合成代数的增加,分布的尾部消失,代密度向均值偏移这种模式意味着,随着时间的推移,主要在合成数据上训练的模型的世代变化越来越小,分布也不那么广泛。作者证明,这种现象发生在各种模型类型中,包括高斯混合模型和法学硕士。这项研究强调了人工生成数据对训练有能力的法学硕士的持续重要性,这些数据可以产生各种各样的内容。

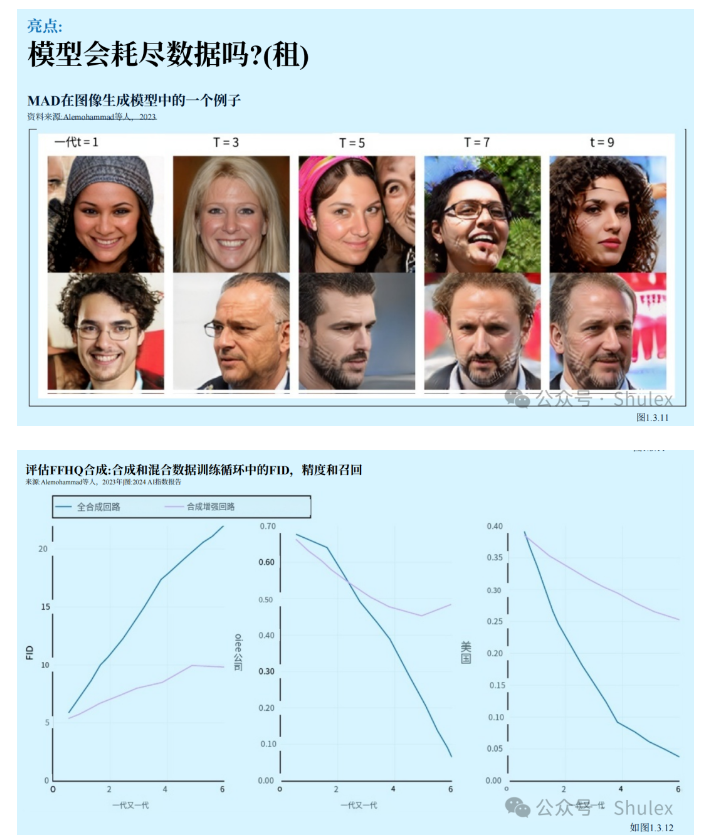

在2023年发表的类似研究中使用对于生成成像模型中的合成数据,研究人员发现,仅在合成数据周期上训练的生成图像模型——或者在真实人类数据不足的情况下训练的生成图像模型,输出质量会显著下降。作者将这种现象标记为模型自噬障碍(MAD),参考疯牛病。该研究检查了两种类型的训练过程:完全合成,即模型完全根据合成数据进行训练,以及合成增强,其中,模型在合成数据和真实数据的混合上进行训练。在这两种场景中,随着训练代数的增加,图1.3.1生成的图像下降。

图1.3.11突出显示了使用合成数据增强的模型的退化图像世代;例如,第7步和第9步生成的人脸越来越多地显示出奇怪的hash标记。来自统计数据合成数据和合成增强循环生成的图像具有较高的FID分数(表明与真实图像的相似性较低),较低的精度分数(表明真实感或质量降低)和较低的召回分数(表明多样性降低)(图1.3.12)。而合成增强循环,其中包含了一些真实的数据显示出比完全合成环路更少的退化,但随着进一步的训练,这两种方法的收益都会递减。

基础模型

基础模型代表了一个快速发展和流行的AI模型类别。它们在庞大的数据集上训练,用途广泛,适用于众多下游应用。诸如GPT-4、Claude 3和羊驼2等基础模型展示了非凡的能力,并且越来越多地部署在现实场景中。生态系统图于2023年推出,是斯坦福大学的一个新的社区资源,用于跟踪基础模型生态系统,包括数据集、模型和应用程序。本节使用来自生态系统图的数据来研究基础模型随时间的趋势

Model Release

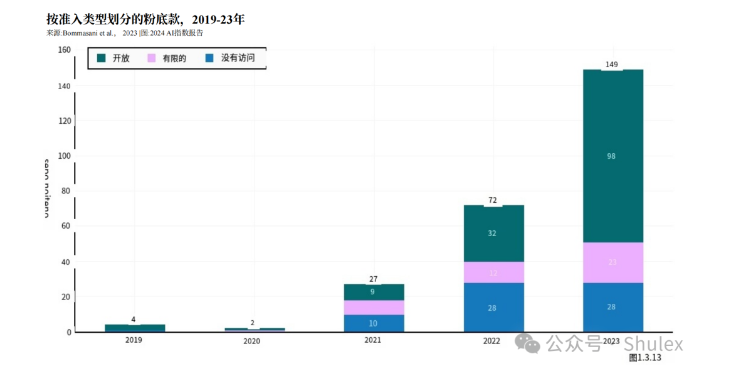

基础模型可以通过不同的方式访问。无访问模型,比如谷歌的PaLM-E,只有开发者可以访问。有限访问模型,如OpenAI的GPT-4,通常通过公共API提供对模型的有限访问。开放模型,如Meta的羊驼2,完全释放模型的重量,这意味着模型可以修改和自由使用。图1.3.13可视化了2019年以来按接入类型划分的基础模型总数。近年来,基础模型数量急剧上升,自2022年以来增长了一倍多,自2019年以来增长了近38倍。在2023年发布的149款基础款中,98款是开放的,23款是受限的,28款是不可访问的。

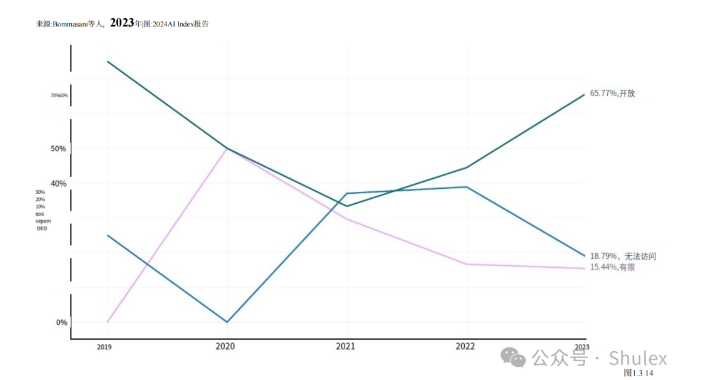

2023年,大多数基础模型都是开放获取的(65.8%),18.8%的模型没有访问权限,15.4%的模型有限制访问权限(图1.3.14)。从2021年开始,以开放获取方式发布的模型比例有了明显的提升。

人事关系

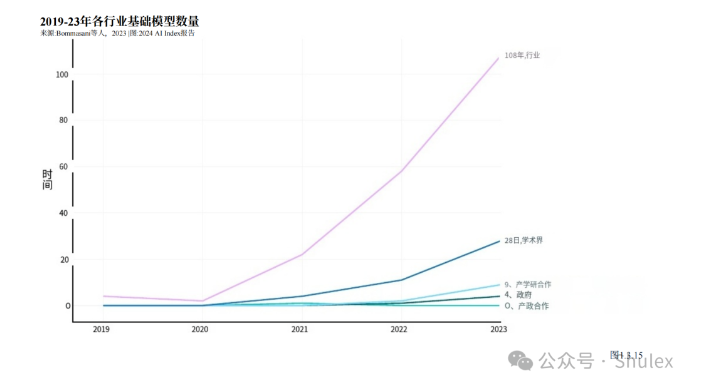

图1.3.15绘制了自2019年以来基金会模型的起源部门。2023年,大部分基础模型(72.5%)来源于工业。2023年只有18.8%的基础模型来源于学术界。自2019年以来,越来越多的基础模型来自工业界。

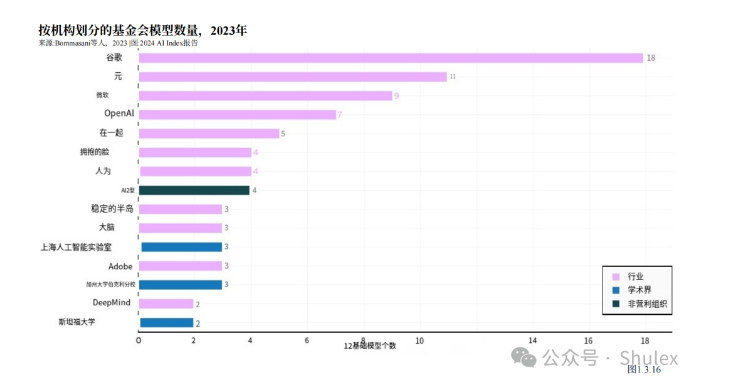

图1.3.16突出显示了2023年发布的各种基础模型的来源 。Google推出的模型最多 (18个 ),其次是 Meta(11图1.3.16突出显示了2023年发布的各种基础模型的来源。Google推出的模型最多(18个),其次是Meta(11个)和微软(9个)。2023年发布最多基础模型的学术机构是加州大学伯克利分校(3个)。

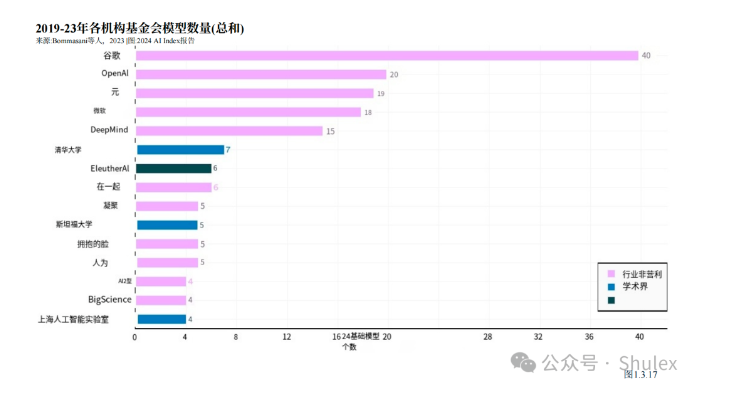

2019年以来,Google发布的基础模型最多,共40个,其次是OpenAI, 20个(图1.3.17)。清华大学在非西方机构中脱颖而出,发布了7个基础模型,而斯坦福大学则是美国领先的学术机构,发布了5个。

国家关系

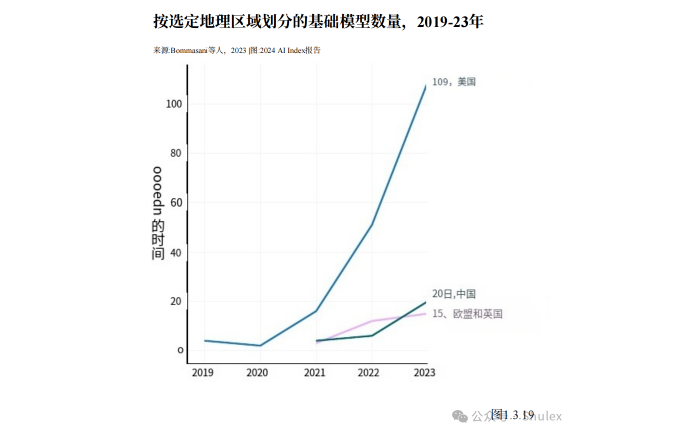

鉴于基础模型在前沿AI研究中具有相当的代表性,从地缘政治的角度来看,了解它们的国家归属是很重要的。图1.3.18、1.3.19和1.3.20可视化了各种基础模型的国家隶属关系。与本章前面提出的值得注意的模型分析一样,如果为该模型作出贡献的研究人员隶属于总部设在该国的机构,则该模型被视为隶属于该国。2023年,世界上大部分的基础模型都来自美国(109个),其次是中国(20个)和英国(图1.3.18)。自2019年以来,美国一直领先于大多数基础模型的起源(图1.3.19)。

图1.3.20描绘了自2019年以来发布并归属于各自国家的基础模型的累计计数。2019年以来发布的基础模型数量最多的国家是美国(182个),其次是中国(30个)和英国(21个)。

训练费用

在关于基础模型的讨论中,一个突出的话题是它们的推测成本。虽然AI公司很少披露训练模型所涉及的费用,但人们普遍认为,这些成本高达数百万美元,而且还在上升。例如,OpenAI的首席执行官萨姆·奥特曼(Sam Altman)提到,GPT-4的培训成本超过1亿美元。培训费用的上涨实际上排除了传统的AI研究中心大学开发自己的前沿基础模型的可能性。作为回应,政策倡议,如拜登总统关于AI的行政命令,试图通过创建国家AI,在产业界和学术界之间创造公平的竞争环境研究资源,这将为非工业参与者提供进行更高级别人工智能研究所需的计算和数据。

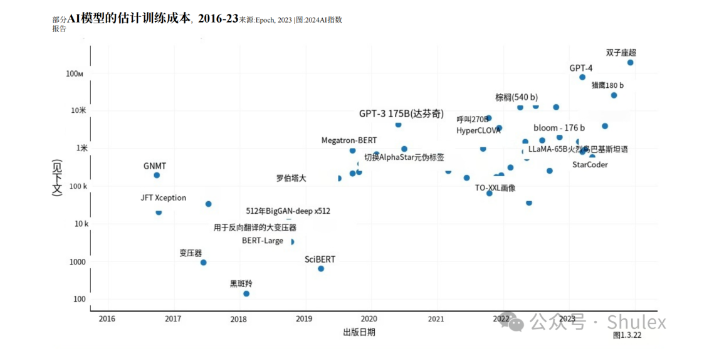

了解训练AI模型的成本很重要,但关于这些成本的详细信息仍然很少。在去年的出版物中,人工智能指数是首批提供基础模型培训成本估算的机构之一。今年,人工智能指数与AI研究机构Epoch AI合作,大幅提高和巩固其AI培训成本估算的稳健性为了估算尖端模型的成本,Epoch团队利用与模型相关的出版物、新闻稿或技术报告中的信息,分析了训练持续时间,以及训练硬件的类型、数量和利用率图1.3.21显示了基于云计算租赁价格的与选定AI模型相关的估计培训成本。人工智能指数的估计证实了近年来模型培训成本显著增加的怀疑。例如,2017年,最初的Transformer模型引入了支撑几乎所有现代LLM的架构,其培训成本约为900美元112019年发布的RoBERTa Large在SQuAD和GLUE等许多规范理解基准上取得了最先进的结果,其训练成本约为16万美元。时间快进到2023年,OpenAI的GPT-4和谷歌的Gemini Ultra的培训成本估计分别在7800万美元和1.91亿美元左右。

图1.3.22可视化了AI指数估算的所有AI模型的训练成本。如图所示,随着时间的推移,模型训练成本急剧增加。

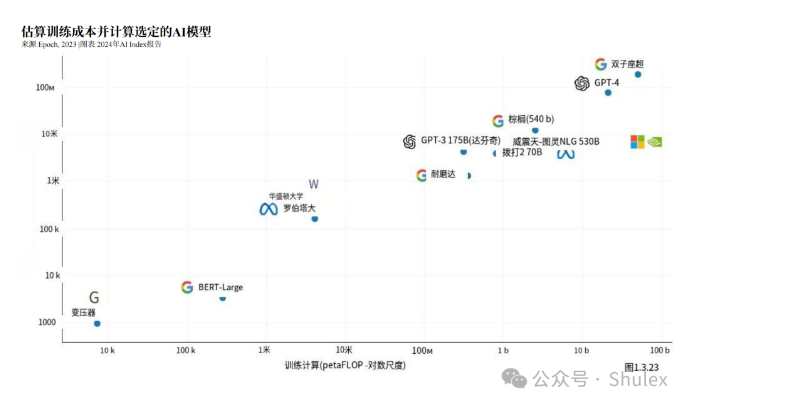

正如之前的AI指数报告所述,AI模型的训练成本与其计算需求之间存在直接关联。如图1.3.23所示,具有更大计算训练需求的模型的训练成本要高得多。

part4AI会议是研究人员展示他们的发现并与同行和合作者建立联系的重要平台。在过去的二十年里,这些会议在规模、数量和声望上都有所扩大。本节探讨出席主要AI会议的趋势。

1.4 AI会议

参加会议

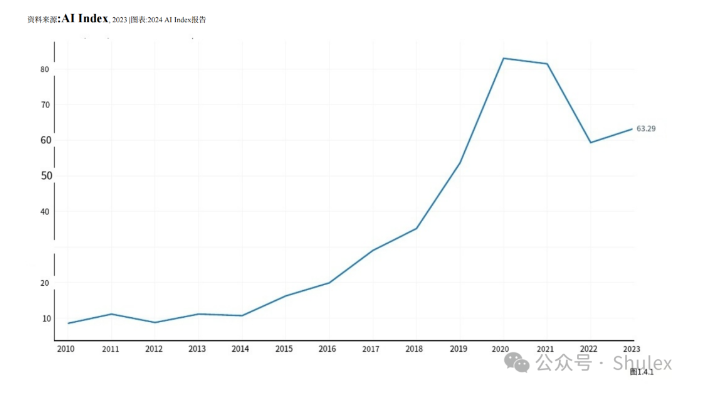

图1.4.1自2010年以来AI会议的出席情况。AI指数报告称,在出席率下降(可能是由于转向完全面对面的形式)之后,从2022年到2023.12年,会议出席率有所增加,具体而言,去年总出席率增长了6.7%。自2015年以来,每年的与会者人数增加了约5万人,这不仅反映了人们对AI研究的兴趣日益浓厚,也反映了新的AI会议的出现。

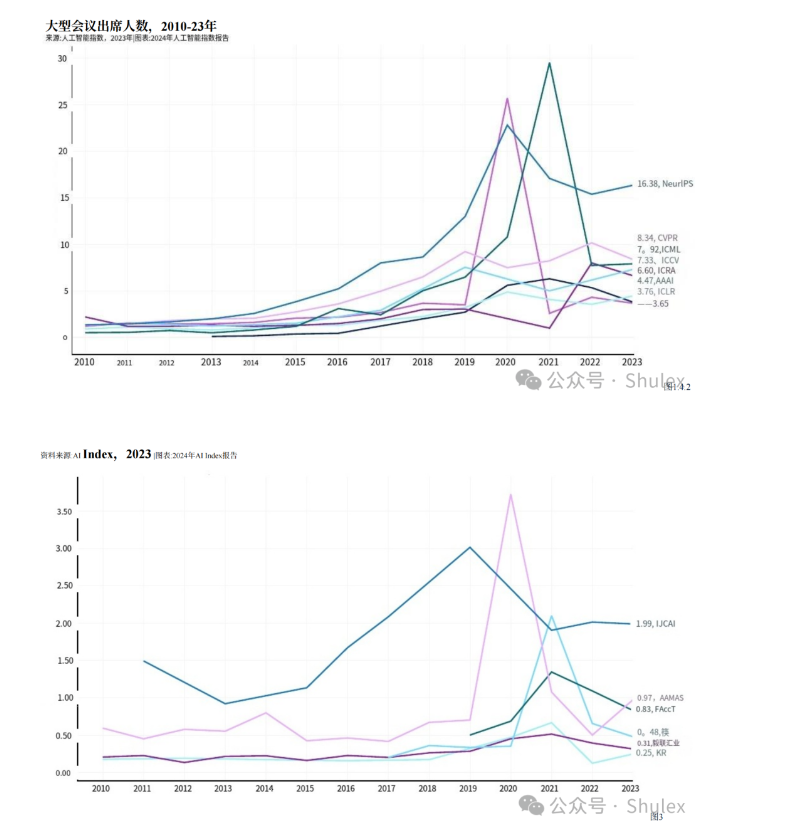

神经信息处理系统(NeurIPS)仍然是参加人数最多的AI会议之一,在2023年吸引了大约16,380名参与者(图1.4.2和图1.4.3)。在主要的人工智能会议中,NeurIPS、ICML、ICCV和AAAI的出席人数逐年增加。然而,在过去的一年里,CVPR、ICRA、ICLR和IROS的出席人数略有下降。

part5GitHub是一个基于web的平台,使个人和团队能够托管,审查和协作代码库。GitHub被软件开发人员广泛使用,有助于代码管理、项目协作和开源软件支持。本节利用来自GitHub的数据,提供了对学术出版数据中未反映的开源人工智能软件开发的更广泛趋势的见解。

1.5 开源人工智能软件

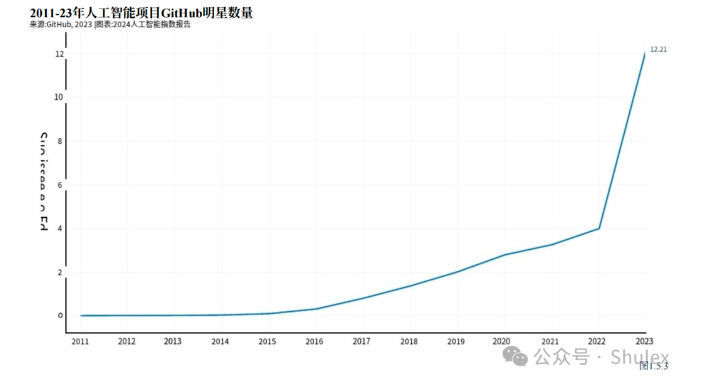

GitHub项目由一组文件组成,包括源代码、文档、配置文件和图像,这些文件共同构成了一个软件项目。图1.5.1显示了github 人工智能项目随时间变化的总数。自2011年以来,与人工智能相关的GitHub项目数量持续增长,从2011年的845个增长到2023年的180万个。值得注意的是,仅去年一年,GitHub人工智能项目总数就急剧增长了59.3%。

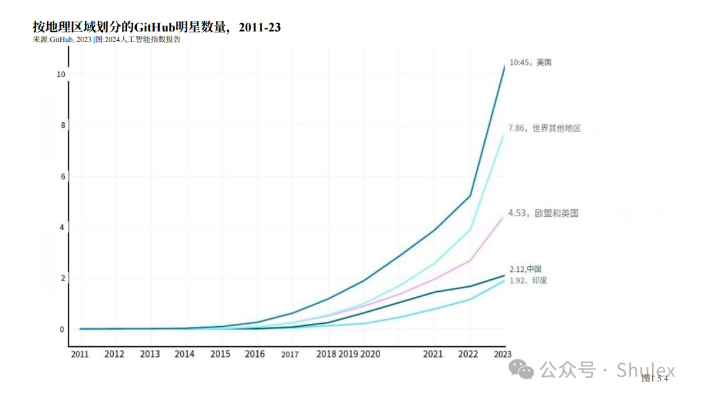

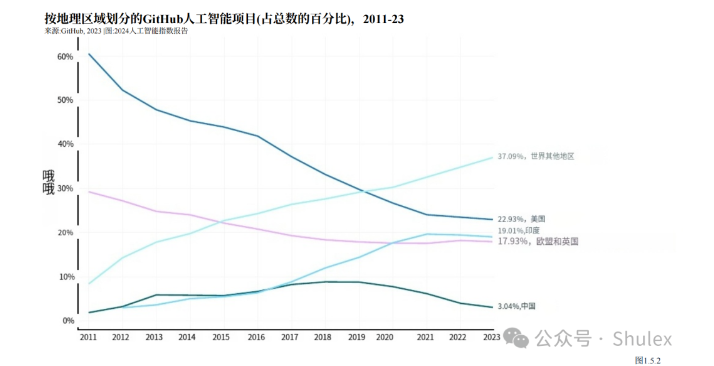

图1.5.2报告了2011年以来按地理区域划分的GitHub人工智能项目。截至2023年,GitHub人工智能项目的很大一部分位于美国,占贡献的22.9%。印度是第二大贡献者,占19.0%,紧随其后的是欧洲联盟和英国,占17.9%。值得注意的是,自2016年以来,美国开发者在GitHub上的人工智能项目比例一直在稳步下降。

明星

GitHub用户可以通过“点赞”来表达他们对某个存储库的兴趣,这一功能类似于在社交媒体上给帖子点赞,表示对开源项目的支持。其中最受欢迎的库是TensorFlow、OpenCV、Keras和PyTorch等库,它们在人工智能编码社区的软件开发人员中广受欢迎。例如,TensorFlow是一个用于构建和部署机器学习模型的流行库。OpenCV是一个为计算机视觉提供各种工具的平台,例如对象检测和特征提取。GitHub上人工智能相关项目的星级总数在去年大幅增加,从2022年的400万增加到2023年的1220万,增加了两倍多(图1.5.3)。GitHub明星数量的急剧增加,以及此前报道的项目数量的增加,突显了开源人工智能软件开发的加速增长。

2023年,美国是获得GitHub星级最多的国家,共计1050万颗(图1.5.4)。包括欧盟和英国、中国和印度在内的所有主要地理区域,授予其所在国家的项目的GitHub星级总数都在逐年增加。